時間:2018-06-24 來源:互聯網 瀏覽量:

版本說明

jdk:1.8

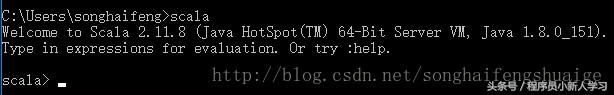

scala:2.11.8

spark:2.3.0

hadoop:2.8.3

環境準備

jdk配置

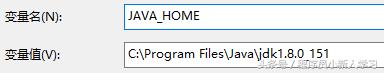

1、配置JAVA_HOME與Path:

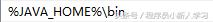

Path

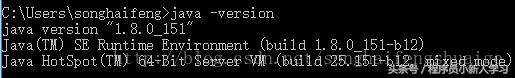

2、驗證配置:

scala安裝與配置

1、scala下載:

訪問官方地址http://www.scala-lang.org/download/2.11.8.html

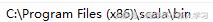

2、配置Path:

3、驗證配置:

Spark安裝與配置

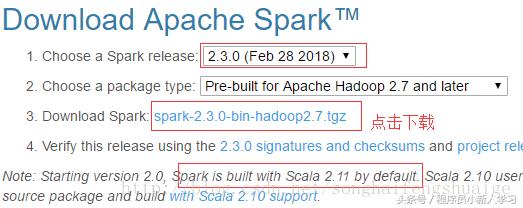

1、spark下載:

訪問官方地址http://spark.apache.org/downloads.html

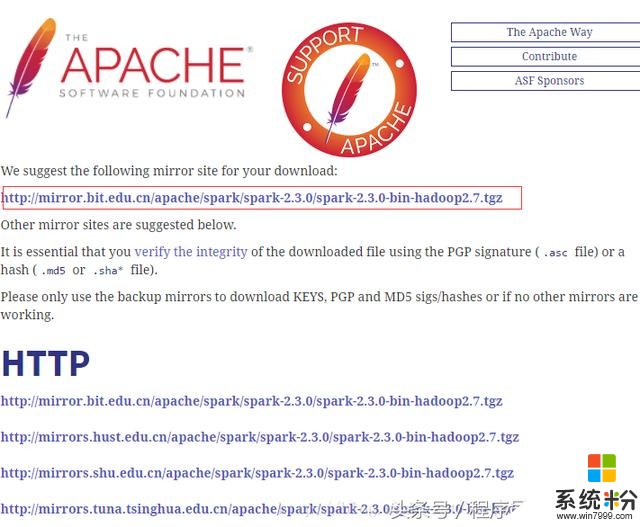

選中官方推薦的地址即可下載,其他地址也可用(建議采用迅雷等下載工具下載,速度比較會快很多)

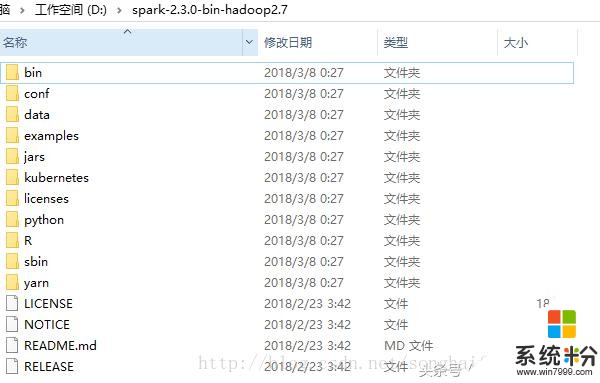

2、解壓至D盤;

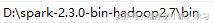

3、配置Path:

4、通過spark-shell進入Spark的交互式命令行模式:

如上,可以看到對應的spark、scala、java版本,同時也看到了異常信息,該異常信息是由於hadoop導致的,下麵來配置hadoop。

Hadoop安裝與配置

1、hadoop下載

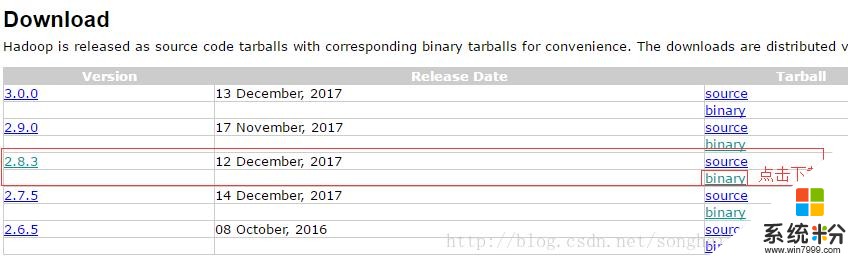

訪問官方http://hadoop.apache.org/releases.html

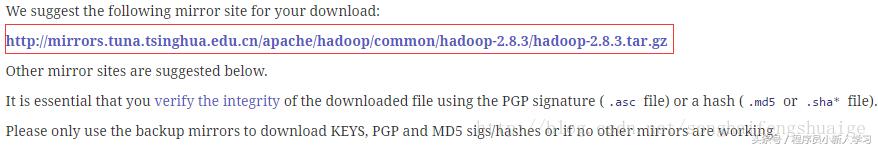

進入下載頁,如下建議地址(同樣建議用迅雷等下載工具下載,速度更快)

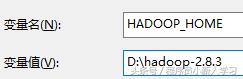

2、解壓至

3、配置HADOOP_HOME&Path:

path:

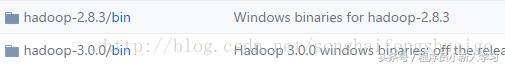

4、winutils下載:https://github.com/steveloughran/winutils

下載對應版本的bin目錄直接替換本地bin目錄即可。

5、此時繼續spark-shell進入spark命令行交互模式:

此時即不會出現上述的異常提示。

6、訪問控製台中的webui如下: